Uncanny Valley: perché una tecnologia più realistica ci mette a disagio?

Pubblicato il 23 giugno 2022

Uncanny Valley (ovvero “valle perturbante”) e può coinvolgere non solo robot e assistenti virtuali, ma anche chatbot e sistemi conversazionali.

Quando ci troviamo a progettare soluzioni tecnologiche in grado di interagire attivamente con gli utenti, è bene tenere conto di un rischio particolare: la sensazione di disagio e repulsione che si prova davanti oggetti o sistemi così realistico da replicare in modo quasi perfetto l’aspetto umano.

Questo effetto ha un nome: Uncanny Valley (ovvero “valle perturbante”) e può coinvolgere non solo robot e assistenti virtuali, ma anche chatbot e sistemi conversazionali. In questo articolo approfondiremo il concetto di Uncanny Valley e le soluzioni possibili nella progettazione di un’intelligenza artificiale empatica.

Uncanny Valley, la “valle oscura” della percezione umana

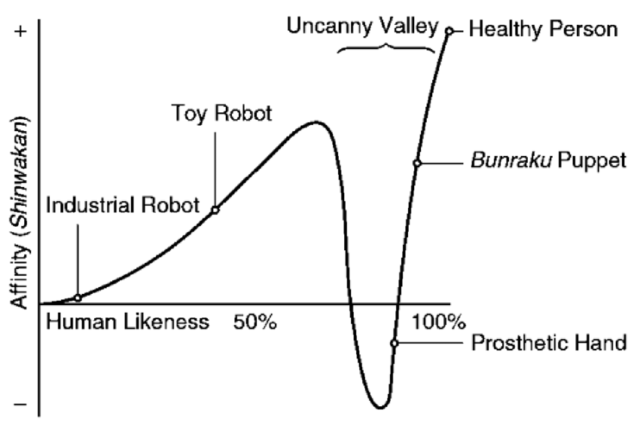

Il termine “Uncanny Valley” risale al 1970 ed è stato coniato da Masahiro Mori, professore di robotica al Tokyo Institute of Technology, in un articolo inizialmente pubblicato sulla rivista giapponese Energy. Masahiro riassume in un grafico il rapporto tra la somiglianza tra un oggetto e un essere umano e il grado di affinità (indicato con il termine shinwakan) che si prova nei suoi confronti.

Come si può osservare nel grafico qui sotto, fino a un certo punto gli osservatori provano maggiore empatia nei confronti degli automi più simili agli esseri umani: un robot giocattolo attira l’attenzione più di un macchinario industriale, perché in qualche modo evoca le fattezze umane pur senza riprodurle con fedeltà. Quando la somiglianza si fa più precisa, tuttavia, la curva della risposta emotiva precipita bruscamente.

Questo avvallamento corrisponde al senso di disagio e inquietudine che gli osservatori provano nei confronti di oggetti che a un primo sguardo sembrano reali, per poi rivelarsi invece artificiali. Questo effetto, rileva inoltre Masahiro, tende ad accentuarsi se entra in gioco la componente del movimento.

Uncanny Valley e prodotti multimediali

Gli esempi che Masahiro riporta per identificare il concetto di Uncanny Valley spaziano dalle applicazioni della robotica industriale ad altri tipi di oggetti inanimati, come bambole e burattini del teatro giapponese, per culminare in rappresentazioni fantastiche come gli zombie.

Nel corso degli ultimi decenni l’Uncanny Valley ha attirato l’interesse degli esperti di tecnologia, rivelandosi più attuale che mai davanti agli ultimi progressi nel campo della robotica, dell’Intelligenza Artificiale e del Machine Learning.

Allo stesso modo il concetto di Uncanny Valley è stato applicato trasversalmente anche a diverse forme di arte e cultura popolare, in particolare nel caso dei prodotti che fanno uso di effetti di computer grafica (CGI).

Sono stati attribuiti all’Uncanny Valley gli scarsi risultati ottenuti al botteghino da film come Final Fantasy: The Spirits Within (2001). Nell’articolo A-Life and the Uncanny in Final Fantasy la studiosa Livia Monnet ipotizza che l’insuccesso della pellicola sia dovuto proprio al suo iperrealismo digitale, tale da causare nello spettatore sensazioni di ostilità.

Cos’è il perturbante? Le origini dell'Uncanny Valley

Sebbene formulato nella sua accezione attuale solo nella seconda metà del ‘900, il concetto di Uncanny Valley affonda le sue radici nella categoria del perturbante (Das Unheimliche) elaborato dal filosofo e psicologo tedesco Ernst Jentsch.

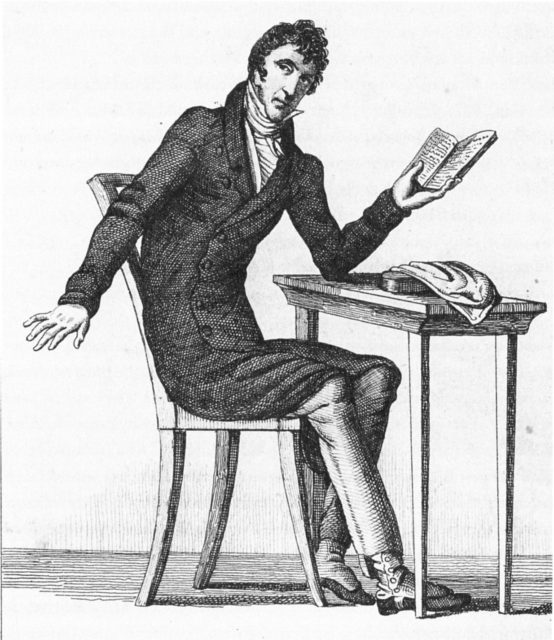

Prendendo come esempio la letteratura del Romanticismo tardo-ottocentesco, come i racconti fantastici di Ernst Theodor Amadeus Hoffmann, Jentsch identifica il perturbante come una sensazione di “incertezza intellettuale” che sorge davanti a oggetti dalle fattezze ambigue come bambole, automi meccanici e manichini di cera.

Sigmund Freud riprende e rielabora il concetto di Unheimlich nell’omonima opera del 1919. Per Freud il perturbante, connesso al processo psicodinamico della rimozione, è “quella sorta di spaventoso che risale a quanto ci è noto da lungo tempo, a ciò che ci è familiare”, che se rivelato provoca in noi uno stato di allerta.

Androidi, cloni e replicanti

Il panorama della tecnologia offre diverse occasioni di spunto sulla possibilità di incorrere nell’effetto di Uncanny Valley, in particolare se si considerano le applicazioni della robotica e dell’Intelligenza Artificiale in diversi contesti professionali e nella vita quotidiana.

Sophia è un robot umanoide sviluppato da Hanson Robotics nel 2016 e dotato di Intelligenza Artificiale, grazie a cui riesce a riprodurre le espressioni facciali con un alto grado di fedeltà. Ormai divenuta una sorta di celebrità, al punto da partecipare a una puntata di talk show insieme al presentatore Jimmy Fallon, Sophia rappresenta per molti l’esempio più lampante di Uncanny Valley.

Se si espande ancora di più il concetto di natura umana, un esempio interessante è invece Ai-Da, un’Intelligenza Artificiale sviluppata nel 2019 con lo scopo di produrre opere d’arte figurativa e performance art. L’esistenza di Ai-Da e delle sue opere, frutto di sofisticati algoritmi, porta il pubblico a porsi quesiti sul rapporto tra umano e macchina e sulla natura dell’arte stessa.

La riproduzione artificiale delle espressioni umane è infine al centro della tecnica dei deepfake. Un deepfake può replicare a tutti gli effetti le fattezze e la voce di una persona grazie al Generative Adversarial Network, una branca del Machine Learning attraverso cui la macchina apprende le caratteristiche e i pattern del personaggio da riprodurre. In questo modo è possibile realizzare video capaci di ingannare in modo convincente molti spettatori, con tutte le ripercussioni etiche e legali del caso.

Chatbot AI e Uncanny Valley

Non tutte le intelligenze artificiali presentano un’interfaccia visiva. Prodotti come gli assistenti vocali e i chatbot possono anch’essi risultare perturbanti: grazie al Natural Language Processing (NLP) essi infatti riproducono in modo sempre più fedele la voce e le strutture linguistiche del discorso umano.

In un’intervista a Wired del 2019 la studiosa di robotica e ricercatrice del MIT Aleksandra Przegalinska fa luce sulla possibilità di incorrere nell’effetto di Uncanny Valley anche in questo tipo di prodotti.

La mancanza di una reazione empatica potrebbe essere una delle ragioni per cui il pubblico tratta spesso con ostilità questi agenti conversazionali, al punto che Siri, l’assistente vocale di Apple, ha un set di risposte pronte per controbattere alle domande più moleste (arrossirei se potessi).

D’altra parte, in parziale contrasto con le affermazioni di Przegalinska, altri studi empirici svolti sull’interazione con i chatbot affermano la mancanza di un effetto Uncanny Valley laddove la componente visiva non sia presente.

Resta comunque ancora una questione aperta: oggi è opinione comune che gli sviluppatori di queste soluzioni debbano garantire agli utenti trasparenza riguardo alla natura dell’agente conversazionale con cui interagiscono, specificando se si tratta di un umano o di un bot.

Conclusioni

In Neosperience non ignoriamo l’importanza di affrontare questi temi: per questo, quando abbiamo progettato Sofia, un’intelligenza artificiale votata ad assistere empaticamente gli utenti, ci siamo posti il problema dell’Uncanny Valley.

Sofia infatti è un assistente virtuale estremamente evoluto, basato sulla piattaforma Neosperience Cloud e sulla tecnologia di NLP Gpt-3 di OpenAI. Oltre a decifrare e interpretare lo stato emotivo dell’interlocutore e ricavarne una profilazione psicologica, grazie al Machine Learning Sofia è capace di formare pensieri compiuti e ampliare il suo linguaggio con l’utilizzo di vocabolari settoriali afferenti alle diverse applicazioni, dalla medicina alla finanza.

Dato lo sviluppo tecnologico delle soluzioni messe in campo per Sofia, per evitare che fosse troppo “perfetta”, abbiamo progettato Sofia in modo da risultare, al contrario dell’androide sua omonima, più meccanica rispetto ad altri assistenti virtuali. In questo modo non corriamo il rischio di ingannare l’interlocutore sulla sua vera natura anche nelle interazioni più brevi o superficiali con l’intelligenza artificiale, instaurando così un rapporto di sicurezza e fiducia.

C’è sempre la possibilità di superare l’Uncanny Valley: man mano che le tecnologie si fanno sempre più sofisticate l’interazione con robot e intelligenze artificiali entrerà presto a fare parte della nostra quotidianità e ci spingerà a superare la paura degli automi.